ChatGPT最近很火,是美国的一家公司开发,他们的官网地址是:https://openai.com/

如何使用ChatGPT?

保姆级使用教程参考(转载自今日头条):https://m.toutiao.com/is/B5shESa/

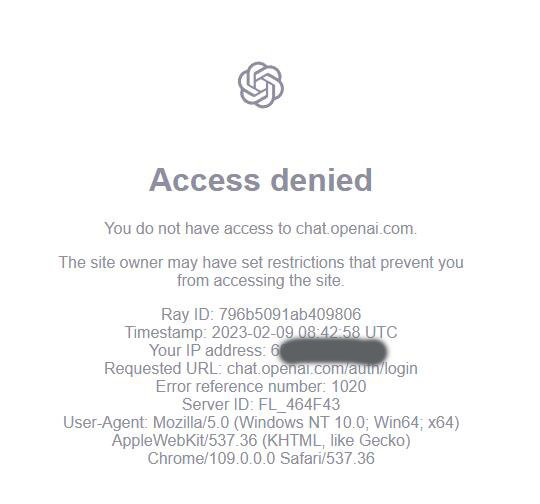

打开ChatGPT注册会员:https://chat.openai.com/auth/login

中国的IP会被暂时限制访问,可能是现在ChatGPT太火,访问的人太多,导致他们的网站经常崩溃,限制访问吧。

如果大家是凑热闹的下载玩玩就算了,等以后国内BAT公司推出类似产品时再去使用。

如真想靠这个做些什么,那你得想办法突破这个限制,如弄一台美国IP的2核2G内存windows系统服务器,通过远程桌面访问ChatGPT网站也是个方法,服务器远程桌面访问方法。

延伸讨论

为什么像ChatGPT的公司不是在我们中国?

个人愚见:ChatGPT的人工智能概念,人工写作,人工对话等并不是什么新鲜的事物,在中国这样的概念和应用早点有了,只是ChatGPT更成熟,性能更强,按我们中国人的聪明,不可能做不到比ChatGPT更好的东西。

今天看到了一个文章,是关于全球云服务器前四大厂商,有微软云、谷歌云,亚马逊云,还有中国的阿里云,阿里云仅占全球市场份额的5%,说是全球市场,实际5%基本都在中国。微软云占到20%以上,全球第二,ChatGPT公司是被微软云收购的,ChatGPT人工智能程序是运行在微软云上,微软云全球算力第二位,算力和深度学习强不强最重要的是GPU显卡硬件数量,但是美国限制英伟达高端GPU芯片出口中国,遭到限制的英伟达GPU芯片包括A100和H100,这二款显卡目前是最好的,单个售价达8万,一台服务器通常需要4张-8张GPU,一台GPU服务器的成本通常超过40万元。国内服务器均价为4万-5万元。这意味着GPU服务器的成本是普通服务器的10倍以上。支撑ChatGPT的算力基础设施至少需要使用上万张英伟达GPU A100显卡算力集群,一次完整的模型训练成本超过1200万美元。这可能就是像ChatGPT公司不是先诞生在中国最主要的原因之一。